억양·감정까지 분석해 자연스러운 음성 응답

한국어 벤치마크서 글로벌 모델 대비 우위 입증

[서울=뉴스핌] 양태훈 기자 = 카카오가 텍스트, 음성, 이미지 정보를 동시에 처리할 수 있는 멀티모달 언어모델 'Kanana-o'를 공개하고, 감정까지 이해하는 대화형 인공지능 기술 경쟁력 강화를 본격화했다.

1일 카카오는 공식 테크블로그를 통해 텍스트·음성·이미지를 통합적으로 이해하고 응답할 수 있는 멀티모달 언어모델 'Kanana-o'의 성능과 개발 후기를 공개했다고 밝혔다.

Kanana-o는 국내 최초로 텍스트, 음성, 이미지 형태의 정보를 동시에 처리하는 통합형 AI 모델이다. 질문이 텍스트·음성·이미지 중 어떤 조합으로 입력되더라도 상황에 맞는 텍스트 또는 음성으로 응답이 가능하도록 설계됐다.

이번 모델은 이미지 처리에 특화된 'Kanana-v', 음성 이해와 생성에 강점을 지닌 'Kanana-a'를 '모델 병합(Model Merging)' 기술로 결합해 개발됐으며, 이후 '병합 학습(Joint Training)'을 통해 세 가지 입력 정보를 통합적으로 학습했다.

Kanana-o는 음성 감정 인식 기술을 활용해 사용자의 억양, 말투, 목소리 떨림 등 비언어적 신호를 분석하고, 대화 맥락에 맞는 감정적이고 자연스러운 음성 응답을 생성할 수 있다. 특히 대규모 한국어 데이터를 기반으로 지역 방언까지 인식하고 표준어로 변환해 자연스러운 한국어 음성 생성이 가능하다.

또한 스트리밍 기반 음성 합성 기술이 적용돼 긴 대기 시간 없이 응답이 이뤄진다. 예컨대 이미지와 함께 "이 그림에 어울리는 동화를 만들어 줘"라고 요청하면, 해당 음성을 인식하고 감정과 상황을 분석해 즉석에서 이야기를 들려주는 방식이다.

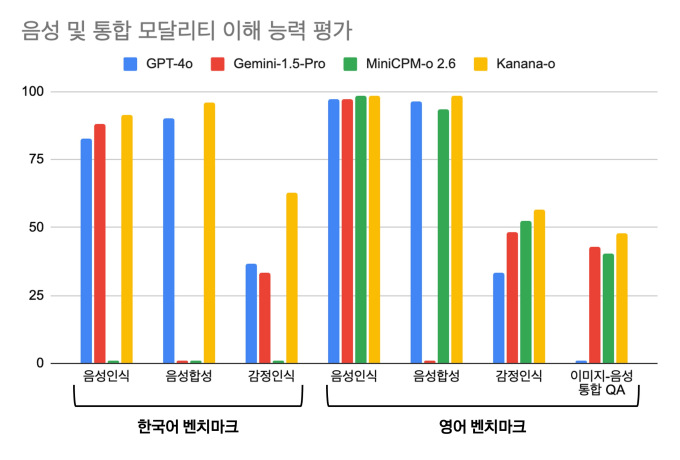

카카오에 따르면, Kanana-o는 한국어 및 영어 벤치마크에서 글로벌 최고 수준의 성능을 기록했으며, 특히 감정 인식 능력에서는 큰 차이를 보이며 경쟁력을 입증했다. 이미지·음성 질의응답 등 복합적 멀티모달 과제에서도 우수한 결과를 나타냈다.

카카오는 향후 Kanana-o를 기반으로 ▲다중 턴 대화 처리 ▲양방향 통신(Full-duplex) 대응 ▲안전한 응답 제공 등을 위한 연구를 지속해, 실제 대화와 유사한 자연스러운 상호작용을 구현해나갈 계획이다.

김병학 카카오 카나나 성과리더는 "카나나 모델은 복합적인 정보를 통합적으로 처리해 텍스트 중심 AI에서 사람처럼 보고, 듣고, 말하며 공감하는 AI로 진화하고 있다"며 "독자 기술 기반의 멀티모달 역량을 통해 인공지능 기술 경쟁력을 강화하고, 연구 결과 공유를 통해 국내 AI 생태계 발전에 기여해 나가겠다"고 밝혔다.

한편, 카카오는 지난해 자체 개발한 AI 모델 'Kanana' 라인업을 공개했으며, 테크블로그를 통해 언어모델, 멀티모달 모델, 비주얼 생성모델 등의 성능과 개발기를 지속적으로 소개해왔다. 올해 2월에는 'Kanana Nano 2.1B'를 깃허브에 오픈소스로 배포하고, 연구 성과를 아카이브(arXiv)에 공개한 바 있다.

dconnect@newspim.com